Kubeflow使用Kubernetes进行机器学习

Kubeflow是Google推出的基于kubernetes环境下的机器学习组件,通过Kubeflow可以实现对TFJob等资源类型定义,可以像部署应用一样完成在TFJob分布式训练模型的过程。最初的设计是将Kubernetes和Tensorflow结合实现对Tensorflow分布式训练的支持。但是仅仅实现对Tensorflow的支持还是远远不够的,Kubeflow社区又陆续对各种深度学习框架进行支持,例如:MXNet, Caffee, PyTorch等。使得机器学习算法同学只需关心算法实现,而后续的模型训练和服务上线都交给平台来做,解放算法同学使其专做自己擅长的事儿。

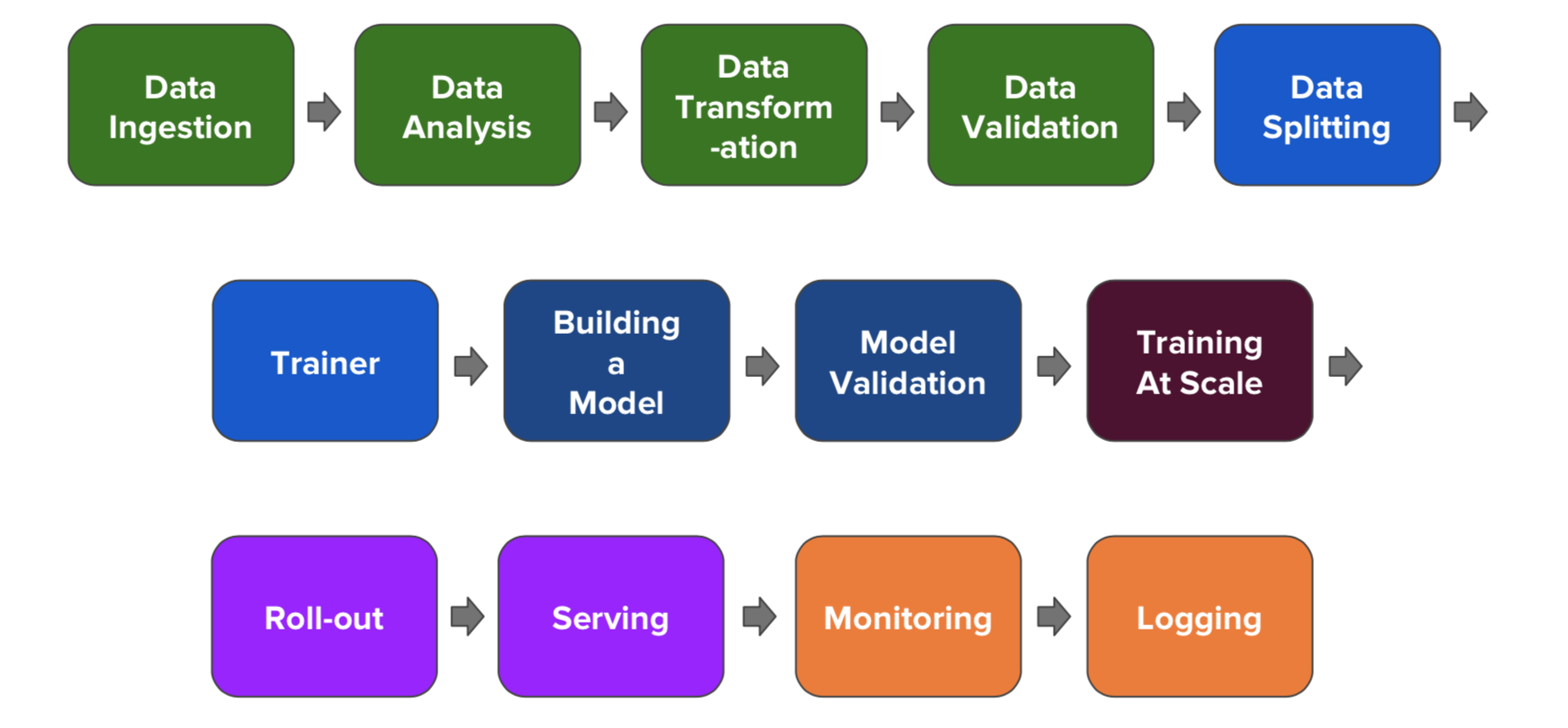

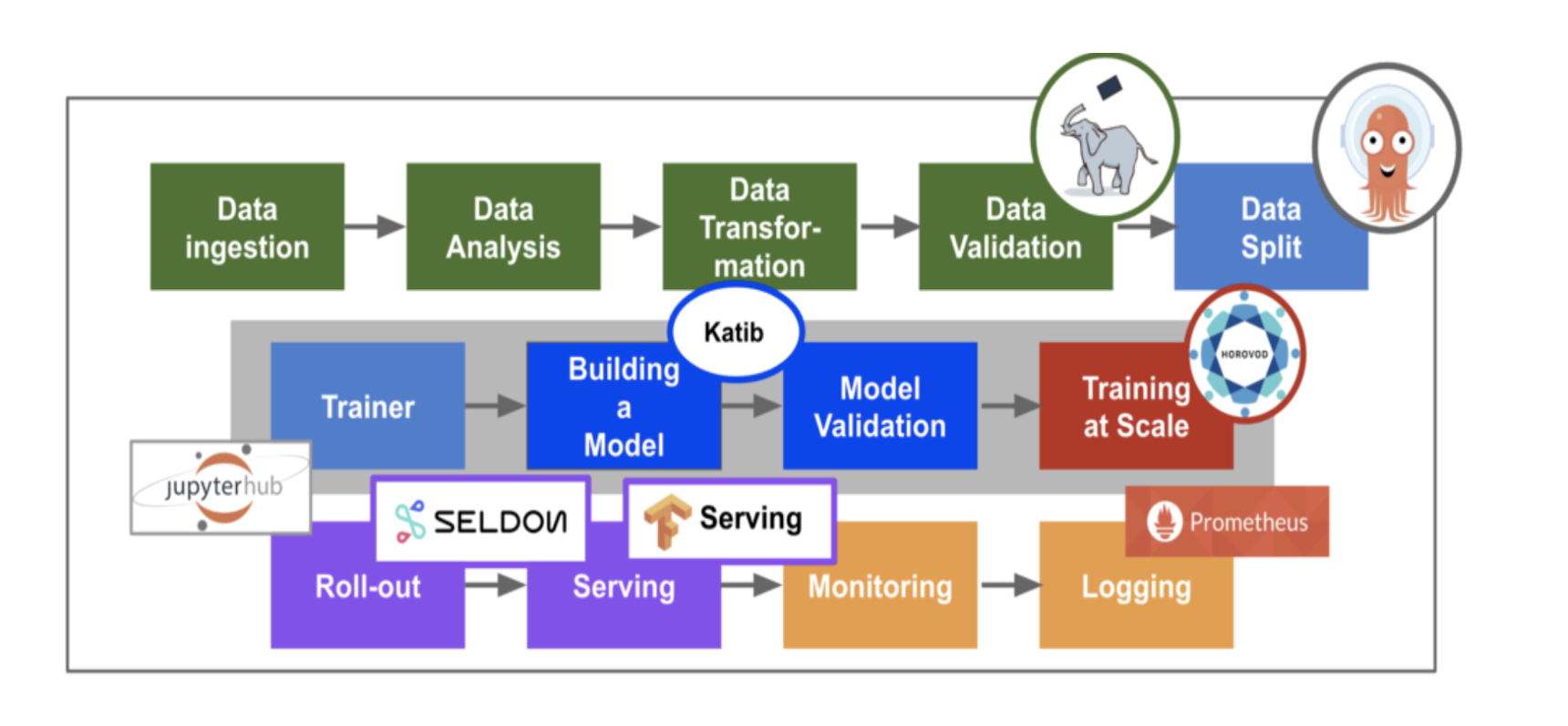

在继续介绍Kubeflow之前, 先简单介绍下真正的机器学习模型服务上线都需要经历哪些阶段,如下图所示:

注意:上图的每种颜色代表对一个阶段的处理

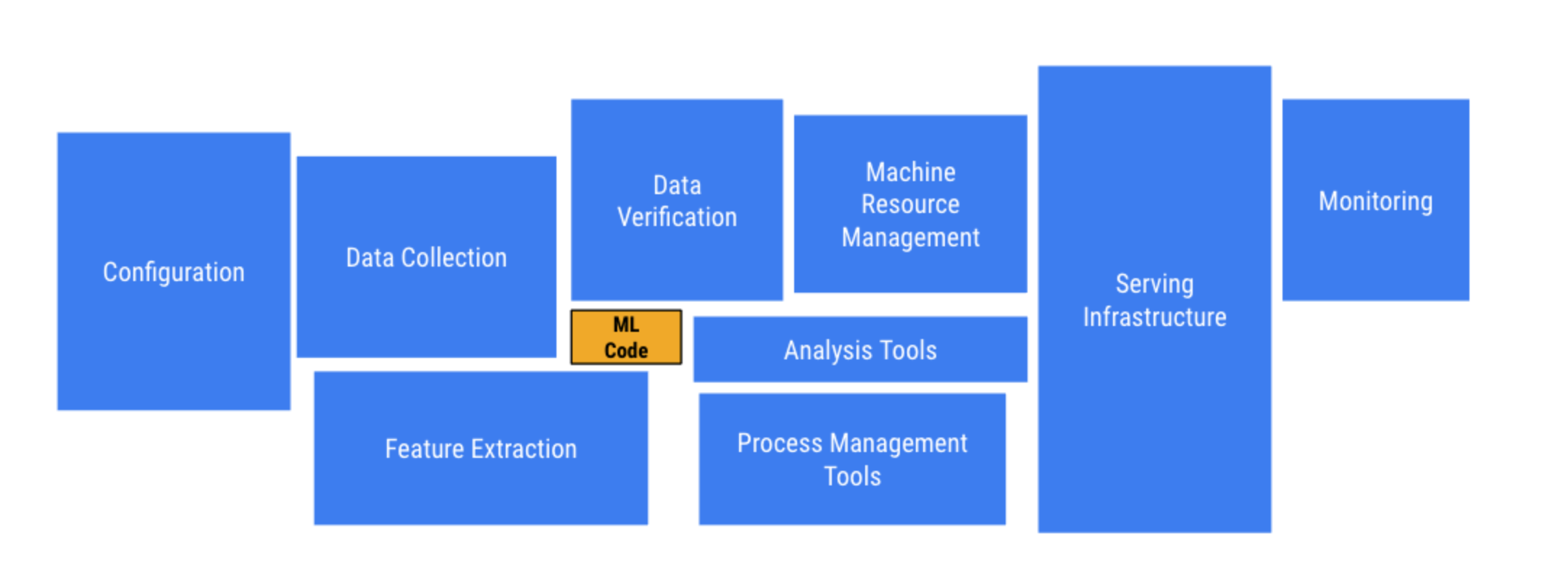

从上图可以看出一个机器学习模型上线对外提供服务要经过:数据清洗验证,数据集切分, 训练,构建验证模型, 大规模训练,模型导出,模型服务上线, 日志监控等阶段。Tensorflow 等计算框架解决了最核心的部分问题,但是距离生产化,产品化,以及企业级机器学习项目开发,还有一段距离。比如: 数据收集, 数据清洗, 特征提取, 计算资源管理, 模型服务, 配置管理, 存储, 监控, 日志等等。

好了机器学习服务上线的基本流程介绍之后,接下来继续介绍Kubeflow.

Kubeflow核心组件介绍

- jupyter 多租户NoteBook服务

- Tensorflow PyTorch MPI MXnet Chainer 当前主要支持的机器学习引擎

- Seldon 提供在Kubernetes上对机器学习模型的部署

- TF-Serving 提供对Tensorflow模型的在线部署,支持版本控制及无需停止线上服务,切换模型等功能

- Argo 基于Kubernetes的工作流引擎

- Ambassador 对外提供统一服务的网关(API Gateway)

- Istio 提供微服务的管理,Telemetry收集

- Ksonnet Kubeflow使用ksonnet来向kubernetes集群部署需要的k8s资源

而Kubeflow利用Kubernetes的优势:

- 原生的资源隔离

- 集群化自动化管理

- 计算资源(CPU/GPU)自动调度

- 对多种分布式存储的支持

- 集成较为成熟的监控,告警

将机器学习各个阶段涉及的组件已微服务的方式进行组合并已容器化的方式进行部署,提供整个流程各个系统的高可用及方便的进行扩展。

Kubeflow 部署安装

实验环境

硬件环境

服务器配置:

- GPU卡型号: Nvidia-Tesla-K80

- 网卡: 千兆(注意:在进行对大数据集进行训练时,千兆的网卡会是瓶颈)

cephfs服务配置:

- 网卡:万兆(注意:通过ceph对数据存储时,ceph集群需要与Kubernetes同机房,否则延迟会对加载数据集的影响非常高)

注意:服务器的GPU驱动和Nvidia-docker2.0的部署安装之前介绍过,这里就不介绍了。

软件环境:

- kubernetes version: v1.12.2(注意: 需要安装kube-dns)

- kubeflow version: v0.3.2

- jsonnet version: v0.11.2

Kubeflow 安装

- 安装ksonnet

1 | export KS_VER=0.11.2 |

关于ksonnet的更多信息请查看官网:https://ksonnet.io/

- 安装Kubeflow

1 | export KUBEFLOW_SRC=/home/wangxigang/kubeflow |

关于kubeflow的更多信息请查看官网:https://v0-3.kubeflow.org/docs/started/getting-started/

当上面的所有安装步骤都正常完成之后,先查看kubeflow在kubernetes集群deployment资源对象的启动状态:

1 | [root@localhost]# kubectl get deployment -n kubeflow |

ok,通过状态我们发现现在服务启动正常,在查看下各个deployment下各个服务的pod的状态:

1 | [root@localhost]# kubectl get pods -n kubeflow |

ok,现在服务都是正常的,接下来让我们通过Ambassador来访问kubeflow部署到k8s集群中的各个组件。

注意: 由于官方默认使用的镜像都是google镜像仓库的,所以在部署时可能出现墙的问题

访问Kubeflow UIs

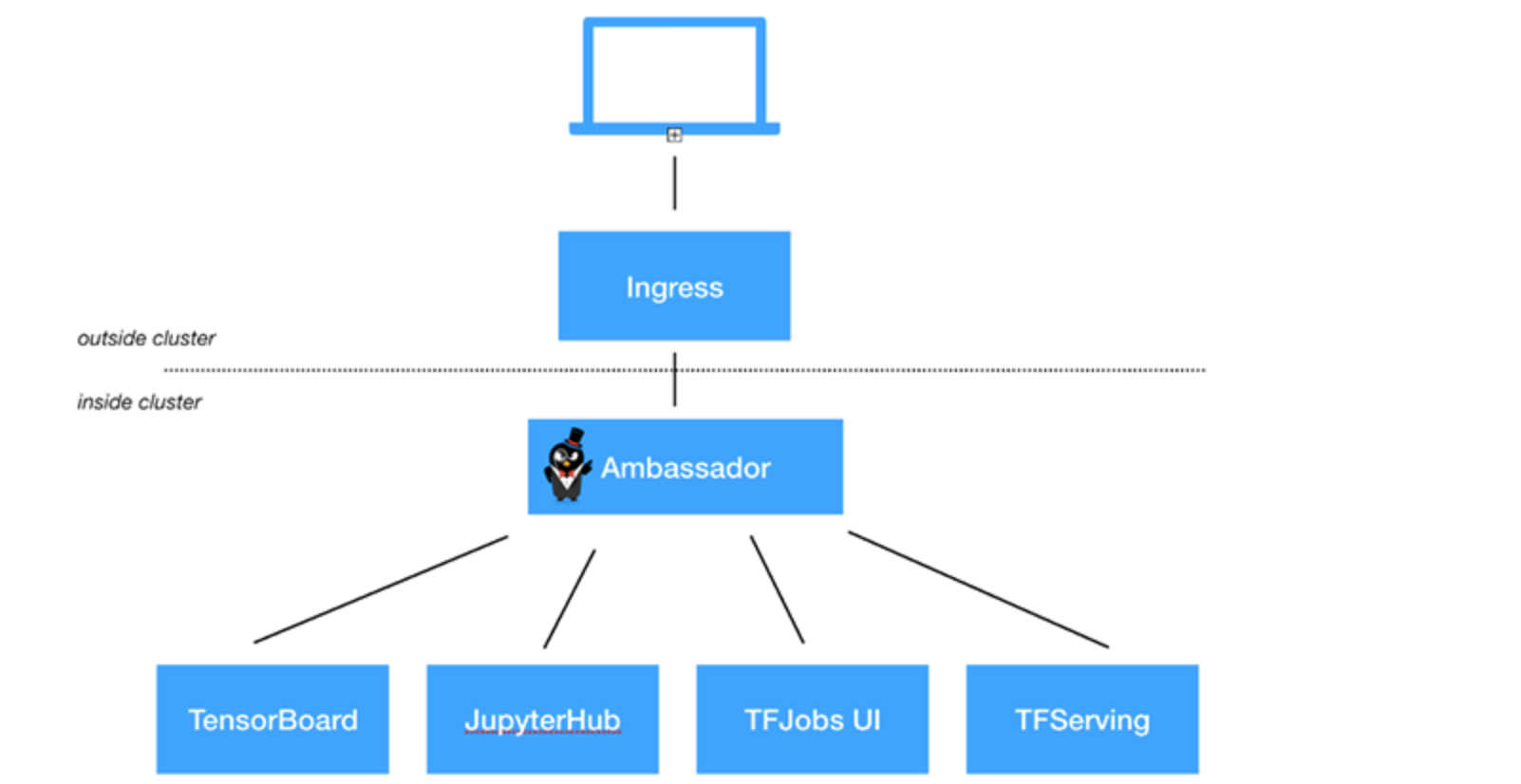

由于Kubeflow使用Ambassador作为kubeflow统一的对外网关,其它的内部服务都是通过使用它来对外提供服务。具体如下图所示:

接下来我们使用kubectl的port-forwarding来对Ambassador Service进行端口转发,在本地对Kubeflow进行访问:

1 | # export NAMESPACE=kubeflow |

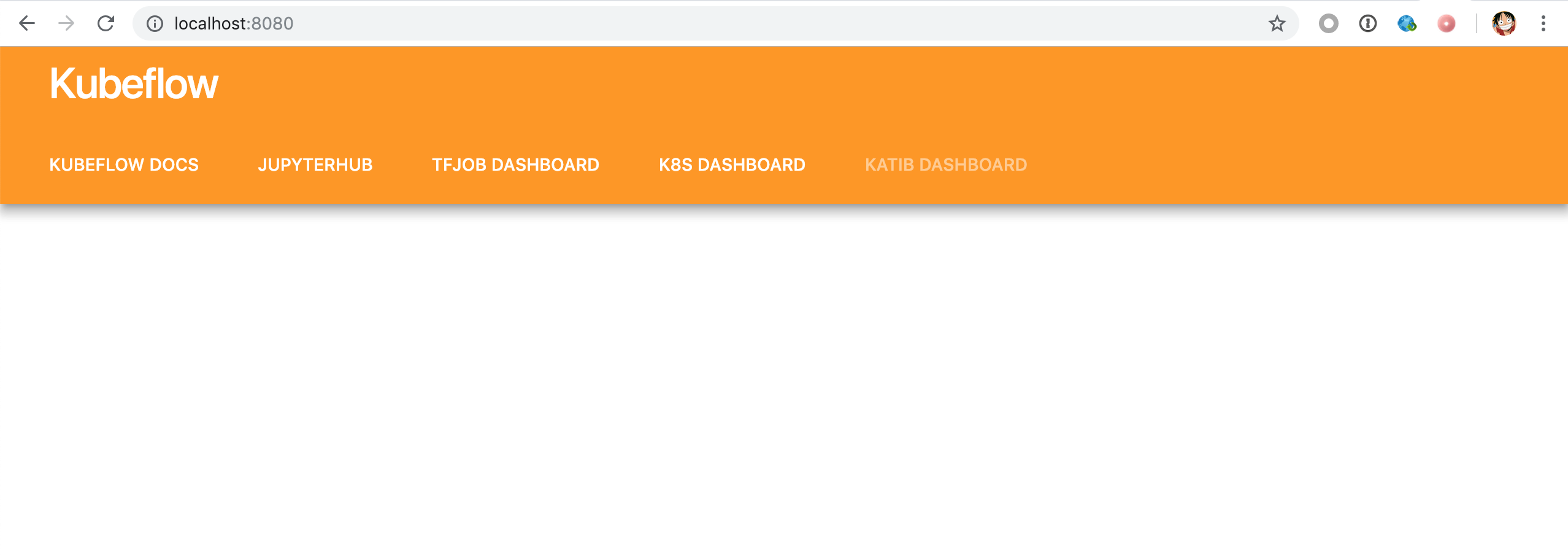

通过浏览器进行本地localhost:8080访问:

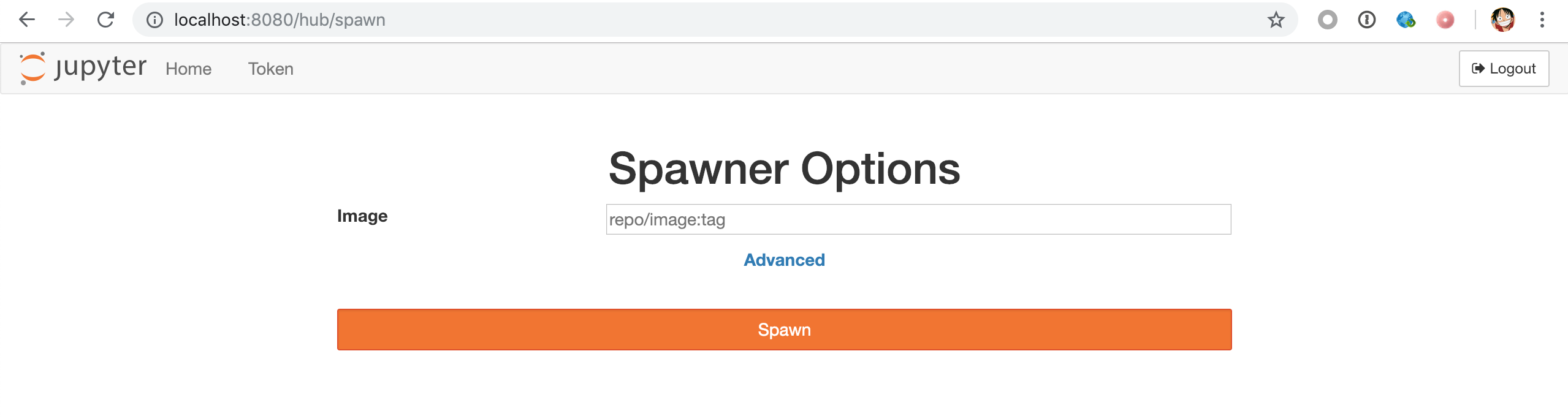

通过Kubeflow UIs可以针对不同的功能进行使用,如使用Jupyter Notebook进行对应用的全过程计算:开发、文档编写、运行代码和展示结果。

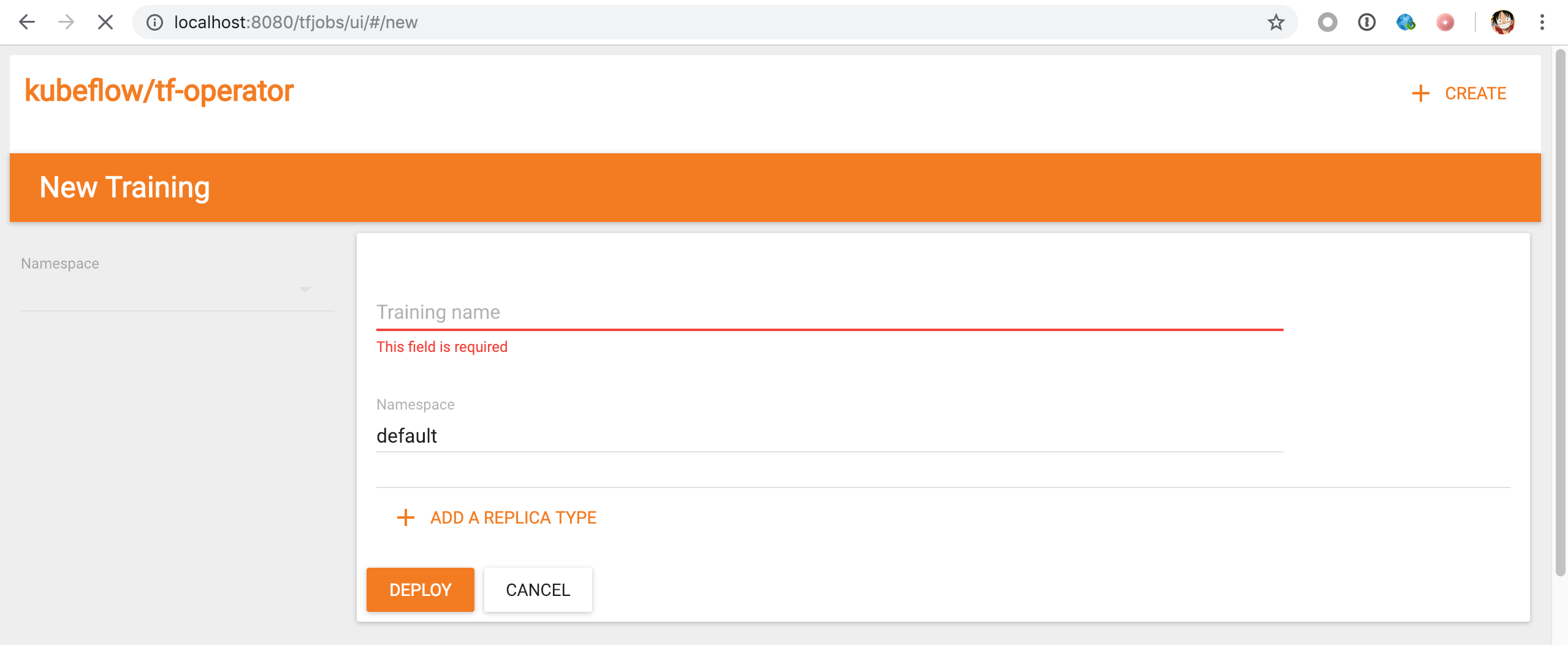

通过Kubeflow UIs访问TF-operator来对基于Tensorflow的模型进行多机多卡的分布式训练。

好了,这篇文章简单的介绍了Kubeflow及其安装流程,关于文章介绍的服务组件太多,需要自行去深入了解了,就不详细介绍了。在接下来的文章会介绍基于kubeflow对Tensorflow和MXNet模型进行多机多卡的分布式训练。

总结

现在国外的Google,微软,亚马逊,Intel以及国内的阿里云,华为云,小米云,京东云, 才云等等公司都在发力Kubeflow,并结合kubernetes对多种机器学习引擎进行多机多卡的大规模训练,这样可以做到对GPU资源的整合,并高效的提高GPU资源利用率,及模型训练的效率。并实现一站式服务,将机器学习服务上线的整个workflow都在Kubernetes平台实现。减轻机器学习算法同学的其它学习成本,专心搞算法。这势必给Devops的同学带来更高的跳挑战。相信未来Kubeflow会发展的更好。